В споре — само собой разумеется, теоретическом, потому что никто такое по сию пору не выстроил — о возможности удержать суперинтеллект «в узде», обеспечивать его безопасность для человека, в далеком прошлом отмечается редкостная свалка. Одна сторона обвиняет другую в нежелании мыслить глобально и стратегически, та напирает на безграмотность соперников в подробностях, и всё это щедро приправлено авторитетными именами, чувствами, паническими настроениями…

Фактически всё это вы понимаете и сами, в случае если смотрите за дискуссией. Но вам будет весьма интересно выяснить, что в ветхом споре раздалась новая нотка: всплыл довод, что ни при каких обстоятельствах не употреблялся обширно, в случае если употреблялся по большому счету. Обращение о доказательстве отечественной неспособности осуществлять контроль поведение суперинтеллекта, сделанное через теорему, сформулированную ровно 80 лет назад не кем иным, как Аланом Тьюрингом. В данной области он трудился несколько, но как раз его взор на проблему вошёл в историю — благодаря запасному инструменту, затмившему славой саму теорему. Инструментом этим была так называемая машина Тьюринга. А сама теорема носит название «неприятности останова» (по крайней мере с некоторых пор её так именуют).

Формулировка несложная: не существует универсального метода, разрешающего выяснить, будет ли произвольная компьютерная программа трудиться вечно («зациклится») либо остановится.

При всей собственной простоте как раз неприятность останова стала основателем интересного класса задач, не поддающихся вычислению. Но для несложного компьютерного пользователя сокровище её пытается к нулю: ну какой суть искать метод выяснить, не зациклится ли произвольно забранная программа, в случае если каждая программа в отечественной власти? Зависла — жмёшь Ctrl-C и всё!

Но кроме того таковой, «обывательский», подход подразумевает, что выкладки Тьюринга в один раз смогут понадобиться: применительно к «умным» вещам, владеющим, как мы знаем, некоей свободой действий, инициативой. Исходя из этого давайте разглядим теорему о проблеме останова подробней — расписав её упрощённое подтверждение (я позаимствовал его у Алекса Аллейна).

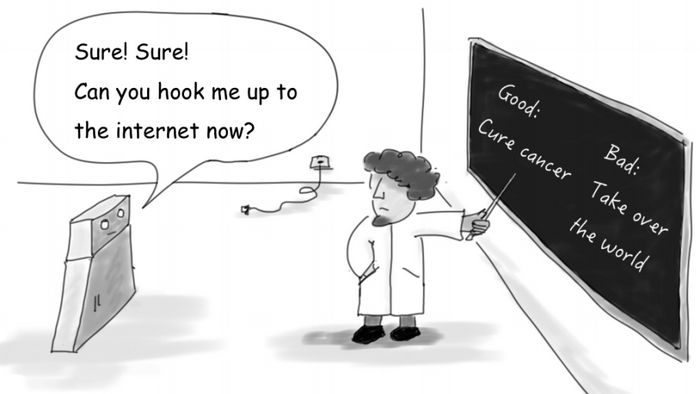

Забегая вперёд: пробовать осуществлять контроль суперинтеллект обучая его «хорошему», само собой разумеется, возможно, но нет гарантии, что он не поступит по-своему при первой возможности либо, что ещё хуже, осознает правила на собственный лад.

Предположим, что теорема неверна. Это указывает, что вероятно написать универсальную утилиту, которая способна выяснить, станет ли произвольный кусок кода, взявший кое-какие вводные эти, трудиться без финиша либо в один раз всё-таки остановится. Назовём такую утилиту DOES-HALT(A,B). Довод A — программа (исходный код), которая подвергается анализу. Довод B — вводные эти для разбираемой программы. Итог: «истина», в случае если разбираемый код останавливается, и «неправда» в другом случае.

DOES-HALT уже сама по себе очень полезная вещица (понадобится как минимум для тестирования программ!), но мы отправимся дальше. Давайте напишем ещё одну утилиту, SELF-HALT, задачей которой будет определять, не зациклится ли произвольный кусок кода, в случае если в качестве вводных разрешённых передать ему самого себя. В случае если код, взявший себя, направляться, пускай SELF-HALT остановится. И напротив: в случае если код, взявший себя, нормально прекращает работу, пускай SELF-HALT зациклится, другими словами трудится вечно. Вот как метод SELF-HALT возможно записать в условных руководствах:

SELF-HALT(program)

{

в случае если (DOES-HALT(program,program)), то вечный_цикл

в противном случае стоп

}

Не ищите тут глубокого смысла, SELF-HALT понадобится нам в качестве запасном логической конструкции для мысленного опыта, что мы на данный момент поставим. Давайте вынудим SELF-HALT проанализировать саму себя. К чему это приведёт?

Итог легко угадать логически. В случае если SELF-HALT отработает и остановится, то DOES-HALT обязана вернуть для неё «истину». Но при таких условиях третья строка SELF-HALT зациклится и останова не случится. Парадокс! То же самое получается, в случае если высказать предположение, что SELF-HALT обязана зациклиться: DOES-HALT вернёт «неправда» и произойдёт останов. Опять несоответствие.

Вынудить один суперинтеллект осуществлять контроль второй суперинтеллект, само собой разумеется, возможно, но кто будет осуществлять контроль контролёров? Сложность увеличивается скоро, последнему в цепочке придётся доверять …

Что же не так, из-за чего работоспособный метод оказывается парализован? В тексте SELF-HALT неточностей нет: она трудится как задумано. Доводы также ни при чём. Получается, виновата утилита DOES-HALT. И вина её лишь в том, что она не может быть написана. Это и имеется подтверждение средствами логики неразрешимости неприятности останова.

Насладившись данной головоломкой поразмыслите вот о чём. Теорема о проблеме останова не говорит, что для раздельно забранной программы (куска кода) нельзя придумать метод, что выяснит — завершится программа либо зациклится. Теорема утверждает лишь, что не существует универсального метода, что решал бы эту задачу для любой программы. Из этого следуют пара занимательных выводов — имеющих, кстати, самый яркий практический суть. К примеру, сейчас легко понять, из-за чего нереально создание совершенного антивируса либо совершенного же фильтра порнографии. Но отечественный разговор о суперинтеллекте — и неприятность останова прикасаясь к нему подводит.

Ориентируясь на логические построения Тьюринга, несколько исследователей из Испании, США и Австралии, написала маленькую, но занятную научную работу, препринт которой лежит на данный момент на arxiv.org (превосходные миниатюры из неё иллюстрируют сегодняшнюю колонку). Основной вопрос: сможем ли мы обеспечивать, что суперинтеллект — неестественный разум, превосходящий создателя — будет вести себя приемлемо для нас? Попросту, не устроит ли он глобальную зачистку Почвы от людей?

Попытаться изолировать суперинтеллект, само собой разумеется, возможно, но изоляция должна быть совершенной, а в противном случае где гарантия, что творение не перехитрит творца?

Ответ, увы, отрицательный, причём взят он посредством той же элементарной логики. Я не рискну излагать тут подтверждение, но упрощённо его сущность в следующем. Суперинтеллект — всего лишь компьютерная программа. Значит, распечатав и проанализировав её, мы помой-му сможем выяснить, поведёт ли она себя враждебно («остановится» либо «зациклится»). Но неприятность в том, что суперинтеллект на то и «супер», дабы мочь всё, что может человек а также больше — в противном случае говоря, такая программа содержит в себе все разработанные программы и а также ту, которая пробует узнать, как суперинтеллект себя поведёт. Раз так, неприятность делается невычисляемой.

Подобные игры с логикой выглядят скорее забавой для ума, нежели чем-то применимым на практике. Но за ними проглядывает тот же самый вывод, что уже много раз делали другие исследователи: единожды сотворённый, суперинтеллект выйдет из под отечественного контроля. А это, по большому счету говоря, значит, что его постройка теряет суть. Представьте, что мы создадим машину так страшную, так непредсказуемую, что будем вынуждены отнять у неё любых контактов с окружающим: страшно делиться с ней информацией, страшно данные от неё приобретать. Но так как это всё равняется, как если бы её не существовало вовсе!

В случае если же покажем слабость и сделаем изоляцию неполной, кроме того самые ярые оптимисты должны будут признать, что угадать, как машина поведёт себя через 60 секунд, час либо сутки, нереально. Посеял ветер – готовься пожать бурю…